AIが消費と結びつくと、現実の偏りが意図しない形で顕著になることもある。

アメリカのアマゾンプライムの当日配達対応地域が、白人の多い地域に偏っていて、黒人の居住地区が外れているという状態も報告された。

「アルゴリズムに人種差別の意図はなく、利益が上がる地域を算出するとそうなったということでしょう。しかし、その結果が、連邦住宅局が指定した黒人居住地区の地図と重なり、歴史的な差別が、現代の情報でも可視化されてしまった」(同)

AIが人の悪意を吸い込むことさえある。2013年には、ハーバード大学教授のラタニア・スウィーニーさんが、アフリカ系の名前が犯罪に関する言葉に紐づけて表示されやすい事例を報告している。

アメリカには、公犯罪歴を集めてデータベース化したサイトがある。人名を検索すると、検索結果にこれらサイトの広告が上がってくる。ヨーロッパ系の名前のジル・シュナイダーには「見つけました」が、アフリカ系のラタニア・ファレルには「逮捕されましたか?」という文字が結びつけられていた。

「文言は実際の犯罪歴とは関係ありませんでした。人種差別の意図はなく、AIは単純に広告の収益率を最大化する選択をしただけです。広告を見た人たちが、アフリカ系の名前と犯罪に関連する言葉の組み合わせを、多くクリックしていた。AIは、社会の悪意を、意図せず吸い込んでしまったのです」(神嶌さん)

こうした問題は、いま、世界的に大きな注目を集めている。昨年12月、ニューラル情報処理システム学会(NIPS)で、ニューヨーク大学教授でマイクロソフトリサーチ主任研究員のケイト・クロフォードさんが、機械学習とバイアスについて問題提起した。

「データ分析技術は、与信、採用、保険、裁判など、さまざまな局面で利用されるようになってきています。性別や人種などの影響を受けず、公平性をいかに確保するかは非常に重要な問題です」(同)

「データに基づくだけでは、現実世界を投影するだけのAIしか生まれません。どうしたいかの部分に人が介在しないと、理想には近づけません」(鎌田さん) (編集部・熊澤志保)

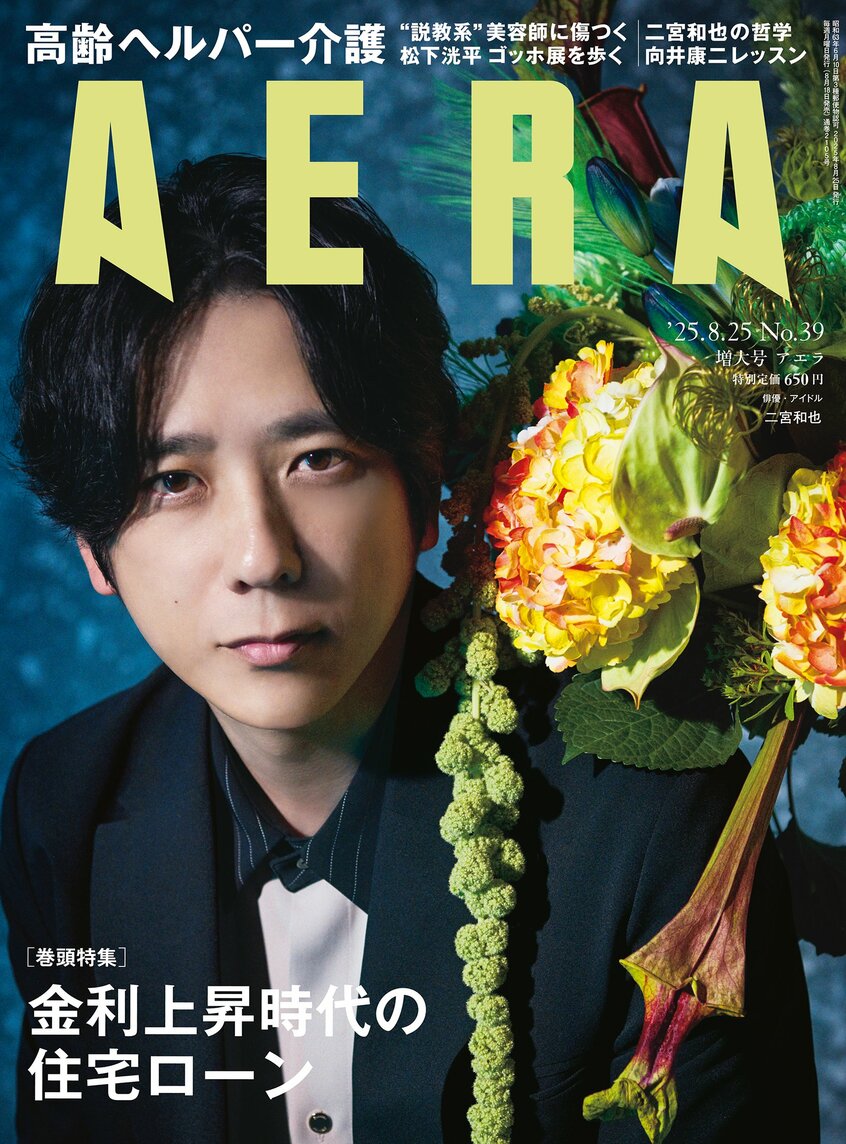

※AERA 2018年5月14日号