人工知能(AI)による採用審査など、日本でもAI社会の広がりを身近に感じるようになった。だが、AIには「女性嫌い」という厄介な偏見があり、「ヘイト」を増幅させる危険性もある。朝日新聞IT専門記者の平和博氏がAIの実態をレポートする。

【写真】人間のクイズ王者に圧勝したことで知られるIBMのAI「ワトソン」

* * *

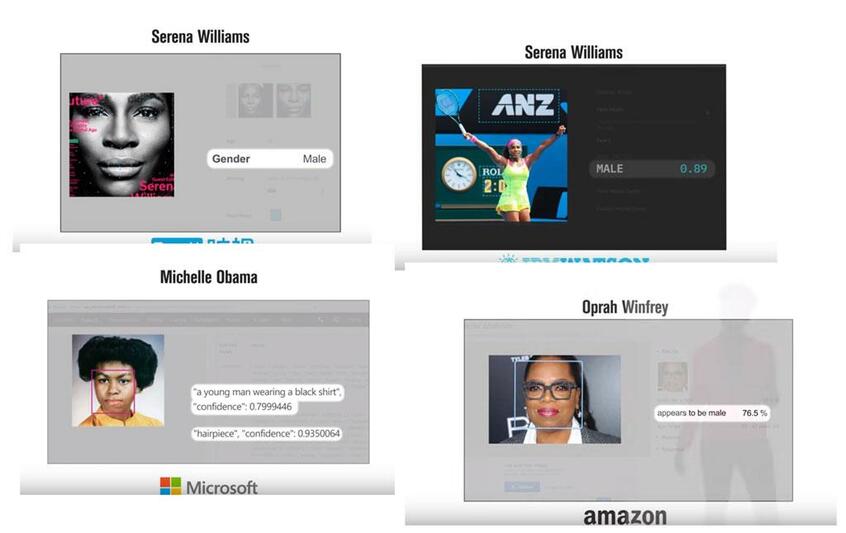

IT5社の人工知能(AI)が男性を女性に間違える割合はコンマ以下。一方、女性を男性に間違える割合は最大で2割近い──。

マサチューセッツ工科大学(MIT)メディアラボの研究者、ジョイ・ブォラムウィニ氏らは今年1月28日、ハワイ・ホノルルで開かれていた米国人工知能学会と米国計算機学会の会議で、AIが人の顔の画像から性別などの特徴を識別する「顔認識」について、IT各社の機能を比較した結果を発表した。

比較したのは、IBM、マイクロソフト、アマゾン、さらに米国のベンチャー「カイロス」と中国のサービス「フェイス++」の5社。その結果には、共通する傾向があった。

いずれも男性を女性に間違える割合は1%未満なのに、女性を男性に間違える割合は、はるかに高かった。最大のアマゾンでは19%。5人に1人の割合で女性を男性と判定するということだ。

つまり、いずれも女性に不利な傾向を示していたのだ。

さらにアマゾンでは、別の観点からもAIによる女性の扱いが問題となっていた。

AIを使った人材採用システムをアマゾンが開発しようとしたが、AIが「女性嫌い」で使い物にならず、断念した──ロイターが2018年10月にそう報じている。

アマゾンは14年に専任チームを立ち上げ、AIによって履歴書を審査するためのシステム開発に取り組み始めた。AIが応募者の履歴書の内容を評価し、5点満点でランク付けする、という仕組みだった。

だが不具合が明らかになる。ソフトウェア開発などの技術職で、女性に対しての評価が低くなるという偏りが生じていたのだ。

原因は、AIが学習したデータにあった。AIは、あらかじめデータを使って学び、その中からモデルとなる特徴を見つけ出す。このモデルに基づいて新しいデータの仕分けなどの作業を行う。だから、学習するデータに問題があれば、AIから出てくる判定結果にも問題が生じる。

●学習データに基づくAI、正確で中立だとは限らない

システム開発に際して担当者たちは、過去10年にわたって同社に提出された履歴書をAIに学習させた。問題は、その大半が男性からのものだったということだ。そして、採用された技術職も大半が男性だ。